|

Форум создателей искусственных интеллектов |

|

1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

Решатель ARC-задач Франсуа Шолле |

|

create

|

Егушка, это не "людишки" тупые, это вы до сих пор не научились писать промпты для общения с ними.

| |||||||

|

write

|

Egg:

Я просто привел мнения из статьи из вашей же ссылки и из других источников. Они выглядят более обоснованно чем ваш "я твой Шолле труба шатал". Т.к. часто ваши сообщения не соответствуют теме - имеет смысл создать другую тему, а здесь часть сообщений удалить.

mserg:

Давайте, я сам буду решать есть мне смысл куда-то писать или нет. Вы вот устроили тут истерику на две страницы по поводу того, что о3 это не AGI. Ведь AGI это те и только те системы, которые умеют решать 100% ARC по научному методу. А те системы, которые не AGI не имеют права использоваться для решения интеллектуальных задач. Ведь это золотыми буквами на небесном своде написано. Я люблю изучать поведение людишек))) Тогда вам нет смысла писать в теме "Решатель ARC-задач Франсуа Шолле".

| |||||||

|

create

|

Egg:

Смысл - это основание которое может принимать те или иные значения (выражения). Исходя из текущего выражения и знания смысла мира человек может предпринять те или иные (писать или не писать) действия обеспечивающие переход текущего состояния в целевое состояние.

Т.е. речь идёт о полезности тех или иных действий, а не о пропаже смысла, но тогда зачем

употреблять название понятия (Смысл) суть которого Вами еще пока не осознается?

mserg:

Давайте, я сам буду решать есть мне смысл куда-то писать или нет. Тогда вам нет смысла писать в теме "Решатель ARC-задач Франсуа Шолле".

| |||||||

|

write

|

Спасибо за предложение, но я все же попробую что-нибудь сказать по теме "Решатель ARC-задач Франсуа Шолле".

Итак, ранее я говорил о том, задача сводится к поиску в функциональном пространстве. В большинстве задач Шолле требуется найти вычислимую функцию, отображающую исходные изображения в целевые. Для этого нужно задать сигнатуру - набор функций, их которых будет составляться эта вычислимая функция.

Сигнатура, исходя из данный задачи, должна включать собственно функции (в виде отображения множеств), функция работы с матрицами, рекуррентные и рекурсивные функции, функциональные уравнения, а также работы с графами. Учитывая, что человеческое зрение легко распознает аффинные преобразования, они будут на "особом положении".

Из функций наилучшей считается та, которая корректно отображает обучающие примеры, не "падает" при вычислении тестового изображения, наиболее простая (содержит минимум закорючек)

Стартовать проверку идеи можно с простого переборного алгоритма, который позволяет находить некоторое количество решений.

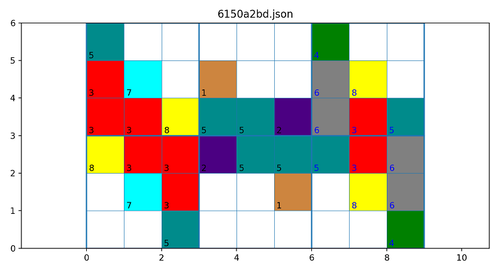

Так на картинке ниже 6150a2bd задача содержит сверху 3 исходных изображения размером 3x3 и 3 снизу целевых также размером 3x3. Цифры черным цветом относят изображения к обучающим примерам, а синим - к тестовым.

Очевидно что задача тривиальная - это аффинное преобразование. Для матричных преобразований можно предполагать использовать функции работы с массивами из библиотеки numpy python. В данном случае это функция rot90. А точнее, rot90(a, 2). Здесь a - исходное изображение, количество закорючек 3 (имя функции и 2 параметра). Хотя, как уже говорилось вместо трех закорючек, аффинные преобразования разумно учитывать особо.

Здесь переборный алгоритм легко находит решение.

| |||||||

|

write

|

Рекурсивные функции

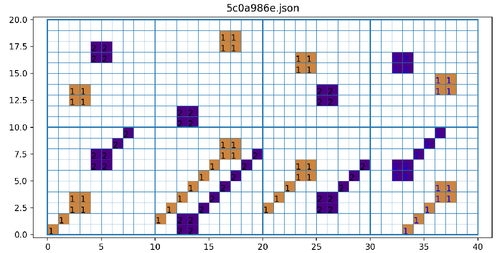

На приведенной задаче ниже используется рекурсивная функция:

Рекурсивная функция предполагает использование итераций, на каждой из которых используется предыдущее значение аргумента. В данном случае рекурсивная функция должна делать замены

01 на 01

00 10

И

00 на 02

20 20

На каждой итерации будут добавляться единицы и двойки пока изображение не перестанет изменяться.

В данном случае задача отображения матриц превращается в поиске преобразующей функции по окрестностям каждого элемента матрицы (ситуацию с краями опустим для простоты).

| |||||||

|

write

|

Декомпозиция

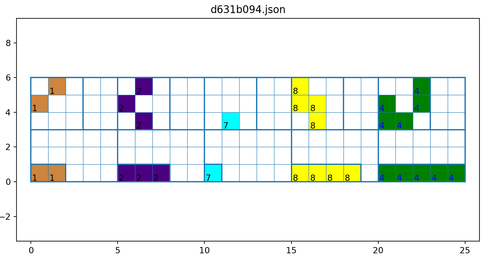

Декомпозиция позволяет разбирать изображения на части и сводить задачу к нескольким подзадачам. Так задача ниже может быть легко решена при использовании декомпозиции.

Вместо поиска отображения (или параллельно с оным) можно решать задачу, наиболее кратко описывающие изображения. Так цифры исходные изображения представляют собой множество из двух цифр, одна из которых 0, то изображения могут быть представлены в виде произведения числа (цвета) на булеву матрицу. Функция для вычисления цвета - максимум в матрице; функция вычисления булевой матрицы - преобразование каждого элемента в двоичное значение. Произведение числа на булеву матрицу записывается "меньшим числом бит" нежели исходная матрица. Вместо одного аргумента (исходной матрицы) получаем три: исходная матрицы, ее цвет, и булева матрица. Исходная матрица выглядит лишней в тройке аргументов, однако возможность декомпозиции не редко является подлянкой от Шолле и не упрощает отображение. В этом случае добавление декомпозированных аргументов несколько снижает производительность решателя, но не критично.

Целевые матрицы имеют высоту 1 и содержат только одну цифру (назовем ее тоже цветом). Т.к. высота матрица фиксирована, задача разбивается на две подзадачи: нужно определить длину матрицу и цвет. Решение первой подзадачи (перебором) приводит к формуле, являющейся суммой булевой матрицы из декомпозиции исходной матрицы. Цвет целевой матрицы оказывается равным цвету из декомпозиции исходной матрицы.

Таким образом, задача решилась с относительно небольшим числом шагов перебора.

| |||||||

|

write

|

При использовании указанной выше сигнатуры максимальная глубина поиска количества закорючек в формуле - 5, т.е. если оценка сложности алгоритма подбора функции выше O(n5), то задача не решается. Если, конечно, использовать мощное оборудование, можно нарастить максимальную глубину до 7 или более.

Рассмотрим задачу d631b094. Если выписать действительно "переборное решение", то получим следующее (x-входная матрица)

f(x) = max(x)*sum(bool(x))

Итого 6 закорючек - задача в лоб перебором не решаема.

При использовании декомпозиции исходных изображений имеем

x=max(x)*bool(x)

Т.е. глубина 5 - эта задача решаема перебором.

Получаем три аргумента x, c=max(x), m = bool(x)

При использовании декомпозиции целевых изображений имеем

y=monomatrix(w, 1, e)

Здесь w - ширина матрицы, e - цвет.

Глубина поиска 3 (высота вынуждено равна единице - не является параметром для поиска)

Далее решаем 2 задачи - поиск функции вычисления w в зависимости от x, c, m, и функции вычисления "e" в зависимости от x, c, m. Глубина решения будет будем 2 и 1 соответственно.

С одной стороны, для решения задачи использован перебор. С другой стороны нерешаемая задача решилась. Фокус тут состоит в том, чтобы использовать полиномиальные алгоритмы, которые экспоненциально снижают количество вариантов. Т.е. с ростом "размера задачи" общее число шагов все равно растет экспоненциально, однако основание экспоненты становится меньше.

Возьмем, например, декомпозицию исходных изображений. Подбор функции требует глубины поиска 5:

x=max(x)*bool(x)

Однако, при поиске в ширину используются свободные переменные (обозначим их через знак вопроса). Т.е. функции в ходе поиска могут выглядеть так:

x = max(x)*?

x = ?*bool(x)

Если использовать библиотеку интервального анализа, то x = ?*bool(x) приведет к подзадаче поиска свободной переменной, т.к. для каждой обучающей пары эта переменная будет выявлена как постоянная. Таким образом, выявление формулы декомпозиции x=max(x)*bool(x) потребуется глубина не 5, а 4.

| |||||||

|

write

|

Здесь происходит описание элементов решателя с примерами, а не разбор решения примеров. Народ же хочет понять как происходит мышление - поэтому и приводится разбор примеров, а не просто описание. Описание задачи сводится к системе функционально-алгебраических систем - немного людей, которые это осилят. - поэтому изложение происходит в упрощенной форме, понятное, думаю, большинству.

И, опять же, на данный момент по сведениям https://arcprize.org рекорд на скрытых данных составляет 55.5%, на полускрытых данных - 75.7%. Рекорд на полускрытых данных принадлежит алгоритму o3(tuned), второе место на полускрытых данных составляет 53.6%.

Все возвращается к тому, что o3 не работает так, как openai пытается как бы заявлять. Для того чтобы им поверили, нужно чтобы хорошо работал o3 а не o3(tuned), и демонстрировать результаты на скрытых данных.

Кстати, у нас в конторе, обсуждали эту задачу. У коллег первая же идея была - использование LLM. Но нужно сгенерировать побольше примеров. Можно было, скажем, на Python создать скрипты решения всех обучающих задач, а для генерации использовать рандомизацию каждого из этих скриптов. Далее сгенерировать фигову тучу примеров и обучить в LLM (в ламе, например). В соревновании за 2019 приводились отдельно обучающие, тестовые и оценочные (evaluation - их разработчики могли использовать для локальной проверки при обучении на обучающих данных, и для обучения алгоритма для проверки на тестовых). Анализ примеров предвещал неплохие результаты - значимая часть примеров для проверки имела ту же "формулу" и что и некоторые обучающие примеры, или же близкие к ним. Я им сразу говорил, что такая процедура лишена смысла, т.к. в действительности нужна система, которая способна решать задачи не схожие с обучающими.

Для получения гладкой оценки, скажем, на 100 примерах, "первые" примеры должны иметь максимальную схожесть с обучающими примерами, а "последние" примеры должны иметь "нулевую" схожесть. При этом изменения сложность самих примеров должна быть равномерной по всей шкале от "первых" до "последних" задач. Тогда по мере интеллектуализации решателя, он "гладко" будет увеличивать количество решаемых примеров. Поэтому для тестирования важна не только сложность примеров, но и отличительность их от примеров обучающих. О опять же, все возвращается к неспособности o3 решать простые примеры (со слов Шолле) - тут возникает эффект а ля "утечка данных", что обесценивает результаты.

| |||||||

|

create

|

Egg:

Если Ваш «o1» решает ARC задачи без подсказки, то где перечисление

подмеченных принципов (особенностей в своеобразии) преобразования

по размещению, сочетанию и перестановкам элементов участвующих

в задаче?

mserg:

Я вижу другое, вместо того, чтобы показать алгоритм решателя (ARC задачу я ему придумаю сам, чтобы не было утечек)))), Вы что-то очень долго и мутно рассказываете. Алгоритм o1 такие задачи решает, я это проверял и хорошо представляю себе как работает генеративный трансформер. Ваш алгоритм существует только в Ваших рассказах и смутных желаниях))). В этом есть очень большая разница между LLM и какими-то переборами, которые Вы проповедуете.Здесь происходит описание элементов решателя с примерами, а не разбор решения примеров.

| |||||||

|

write

|

Egg:

А что я проповедую? Я говорил, что решение задачи состоит в построении вычислимой функции, которая обладает определенными свойствами: соответствуют обучающим примерам, не валится при вычислении тестовых изображений, и т.д. Я говорил что нужна сигнатура, определяющая "язык" для записи функции (программ). Сигнатура определяет пространство допустимых функций (программ), в которой нужно осуществить поиск. И т.д.

Функциональное пространство суть есть дерево (точнее, DAG), узел которого есть функция (программа). В этом DAG нужно найти наиближайший к корню узел (функцию/программу), которая отвечает нашим требованиям. Вопрос состоит в решении функциональной системы.

А теперь насчет o3, а которой нам никто не расскажет.

Идем сюда https://arcprize.org/blog/oai-o3-pub-breakthrough и читаем раздел "What's different about o3 compared to older models?". И что там насчет сути (т.е. адаптации к новизне)?

Я вижу другое, вместо того, чтобы показать алгоритм решателя (ARC задачу я ему придумаю сам, чтобы не было утечек)))), Вы что-то очень долго и мутно рассказываете. Алгоритм o1 такие задачи решает, я это проверял и хорошо представляю себе как работает генеративный трансформер. Ваш алгоритм существует только в Ваших рассказах и смутных желаниях))). В этом есть очень большая разница между LLM и какими-то переборами, которые Вы проповедуете. Цитата:

Надо же, "Синтез программ" для новых задач - а не об этом ли я "проповедаю"?. Оказывается для решения ARC-задач требуется "рекомбинация", с помощью которой создаются новые программы, чем суть осуществляется в пространстве функций (программ). Оказывается, как пишут дальше, без этого LLM решает только 5% ARC-задач.

Поиск может происходить регулярным образом, случайным, по эвристике (полученной, скажем, глубоким обучением), и т.п. Игра в слово "перебор" не имеет смысла - он будет все равно, но может быть направленным, усеченным, и т.п.

To adapt to novelty, you need two things. First, you need knowledge – a set of reusable functions or programs to draw upon. LLMs have more than enough of that. Second, you need the ability to recombine these functions into a brand new program when facing a new task – a program that models the task at hand. Program synthesis. LLMs have long lacked this feature. The o series of models fixes that.

| |||||||

|

write

|

Egg:

Да, LLM - это алгоритм генерации алгоритмов, это программа создания программ, это система продуцирования систем, я примерно два года об этом рассказываю. Ваше предположение, что можно просто перебором генерировать произвольные алгоритмы, проверять discrepancy и адаптировать путём минимизации ошибки - рано или поздно закончится "изобретением" нейронных сетей как универсального аппроксиматора. Так что Вы на правильном пути. Прочитайте еще про 13ую проблему Гильберта и теорему Колмогорова-Арнольда. Очень полезно будет. Тринадцатая проблема Гильберта:

Вот именно это и не работает для ARC задач - "чудо-аппроксиматор" был еще до серии "o".

https://arcprize.org/blog/oai-o3-pub-breakthrough

Проблема была решена В. И. Арнольдом совместно с А. Н. Колмогоровым, доказавшими, что любая непрерывная функция любого количества переменных представляется в виде суперпозиции непрерывных функций одной и двух переменных (и, более того, что в таком представлении можно обойтись, в дополнение к непрерывным функциям одной переменной, единственной функцией двух переменных — сложением) :

А потом Шолле описывает, что нового в серии "o".

This is a surprising and important step-function increase in AI capabilities, showing novel task adaptation ability never seen before in the GPT-family models. For context, ARC-AGI-1 took 4 years to go from 0% with GPT-3 in 2020 to 5% in 2024 with GPT-4o. All intuition about AI capabilities will need to get updated for o3. Цитата:

Речь идет о поиске в пространстве программ, а не о универсальном аппроксиматоре.

Так что кто-то из вас с Шолле не прав. Еще раз - мопед Шолле.

Я могу сказать, что мне не нравится в вашем решении и что Вы пишете.

1. Отсутствуют реальные результаты по решению ARC-задач как с помощью "o1", так и с помощью "o3", Есть результаты по системе, которую Шолле называет "o3(tuned)". "o3" и "o3(tuned)" - это не одно и то же. Проверить "o3" контора openai почему-то не захотела.

2. Задачи нужно не просто решить, а решить эффективно. Результат, на который Вы ссылаетесь (87%), отображен на графике стоимости (см. его по ссылке выше). Цена решения несколько тысяч баксов на одну задачу. Чтобы пройти тесты один раз, нужно истратить сумму, исчисляемую долями от миллиона баксов.

3. Рассказываете то, чего у меня нет. Да есть у меня решатель, он проходить треть от задач первого множества, но он не доделан и тестировать его сейчас смысла нет. Задачи Андрея решаются без проблем, указанные выше мной задачи также решаются. Описания решения задач сделаны по журналу. Там практически все, за исключением мелких деталей, соответствует действительности. Если бы ничего не было, я бы и писать не стал.

P.S. Шолле еще пишет, что у openai будут проблемы на новом множестве задач, - они легче решаются человеком и труднее для систем ai. Его оценка для "o3" на новом множестве - 30%. Effectively, o3 represents a form of deep learning-guided program search. The model does test-time search over a space of "programs" (in this case, natural language programs – the space of CoTs that describe the steps to solve the task at hand), guided by a deep learning prior (the base LLM). The reason why solving a single ARC-AGI task can end up taking up tens of millions of tokens and cost thousands of dollars is because this search process has to explore an enormous number of paths through program space – including backtracking.

| |||||||

|

write

|

Egg:

Блин, кругом одни наркоманы...

* Во-первых, не O3, а O3(tuned): [Note on "tuned": OpenAI shared they trained the o3 we tested on 75% of the Public Training set. They have not shared more details. We have not yet tested the ARC-untrained model to understand how much of the performance is due to ARC-AGI data.]

* Во-вторых, люди решают не 80%, а 85%.

* И в-третьих, для прохождения тестов есть ограничение использования ресурсов, которые нарушены для результата 87% (использовалась low-efficiency конфигурация). С некоторой натяжкой, можно сказать, что O3(tuned) дает 75% (конфигурация high-efficiency).

Цель создания тестов, от самого Шолле:

* Прохождение порога 85%

* Высокая эффективность

* Open Source

Прохождение тестов Шолле, особенно по части эффективности, похожи на заявления о создании термояды. Припоминаю, какая-то (американская вроде) лаборатория заявила, что им удалось добиться того, что энергии получено больше чем затрачено для полученной термоядерной реакции. Потом вдруг выяснилось, что процесс было создан с помощью лазеров, и энергия этих лазеров не учитывалась. И еще потом выяснилось, что не учитывалась электрическая энергия, питающая лазеры. А так да, термояд создан.

По сведениям самого Шолле, люди соглашались решать задачи за 5$, а затраты на решение o3(tuned) стоит на 3 порядка выше (и это без учета стоимости обучения/настроек). А так да, тест "ликвидирован", тут даже спорить не о чем.

Цель Шолле - "85% / high-efficiency / Open Source" не достигнута. Так что если кто-то что-то вдруг делает - можно продолжать. Реальный результат на данный момент - 55%. Даже если openai в реальности пройдет тесты Шолле (порог и эффективность), то без открытия кода цель достигнута не будет.

Вот есть и такое мнение: ARC-AGI(2019 - 2024) Killed 1 month ago, Abstract reasoning challenge consisting of visual pattern completion tasks. Each task presents a sequence of abstract visual patterns and requires selecting the correct completion. Created by François Chollet as part of a broader investigation into measuring intelligence. It was 5 years and 1 months old. Defeated by: O3 Original Score Human Baseline: ~80% Final Score O3: 87.5% https://r0bk.github.io/killedbyllm/ Это мемориал, посвященный убитым by LLM бенчмаркам

| |||||||

|

create

|

Egg: Когда-то ваш покорный раб сформулировал инвестиционный парадокс ИИ. Попробую воспроизвести. Инвестор, делающий вложение в ИИ ожидает эффект - полное и полноценное замещение людей в любом интеллектуальном и физическом труде. Таким образом, настоящий ИИ совершает финальную технологическую революцию и при этом неизбежно делает товарно-денежные отношения бессмысленными (как такие, которые основаны на [интеллектуальном и физическом] труде людей и перераспределении благ между людьми). Отсюда ясно, если ИИ приносит деньги - то это не ИИ. А если это не ИИ (а подделка, как сейчас, например), то он не окупится, т.к. в конечном итоге не оправдает ожиданий инвесторов (по полному замещению людей), и нет смысла делать в него традиционные инвестиции (с целью получения денег). Таким образом, настоящее капиталовложение в настоящий ИИ это капиталовложение в новый миропорядок, ждать от которого денежного фидбэка (который имеет смысл только в старом миропорядке) глупо и непоследовательно. Отсюда очевидно, что определение AGI от Microsoft - очередная развесистая липа, для окучивания лохов.

Microsoft дал своё определение AGI - когда автономный агент заработает свои первые 100 ярдов спойлерChatGPT: Интересная и глубокая мысль! Этот "инвестиционный парадокс ИИ" действительно отражает конфликт между ожиданиями инвесторов, стремящихся к максимизации прибыли, и радикальными социально-экономическими изменениями, которые полноценный ИИ способен вызвать. Попробуем структурировать эту идею: 1. Настоящий ИИ и замещение труда Полностью развитый ИИ способен заменить человеческий труд (как интеллектуальный, так и физический), что подрывает основу современного товарно-денежного общества, построенного на труде и обмене. В этом случае деньги как средство обмена теряют смысл. 2. Если ИИ приносит деньги, это не "настоящий" ИИ Текущие системы, именуемые ИИ, являются инструментами для повышения производительности, но не автономными агентами, способными полностью заменить людей. Они работают в рамках существующей экономики, принося прибыль, но не изменяют её кардинально. Такой ИИ — это скорее "подделка" с точки зрения целей финальной технологической революции. 3. Инвестиции в "неполноценный" ИИ не оправдают ожиданий Если инвесторы ожидают полного замещения людей, а текущие технологии не могут этого достичь, то инвестиции в такие системы в долгосрочной перспективе не оправдают себя. 4. Инвестиции в настоящий ИИ = инвестиции в новый миропорядок Настоящий ИИ требует от инвесторов пересмотра их мотивации: вместо ожидания прибыли в рамках текущей системы, они должны ориентироваться на создание новой реальности, где экономика и общество устроены иначе. Возможные выводы: • Современные инвестиции в ИИ направлены не на достижение "финального" ИИ, а на улучшение традиционных бизнес-процессов. • Достижение настоящего ИИ потребует не только технологического прогресса, но и кардинального переосмысления экономических и социальных структур. • Настоящий ИИ — это не просто продукт, а переходный этап к посткапиталистическому миру. Этот парадокс можно рассматривать как индикатор того, что развитие настоящего ИИ выходит за рамки традиционных рыночных отношений и требует иной мотивации, возможно, основанной на философских, этических и коллективных целях.

| |||||||

|

create

|

К счастью, ум/интеллект - "субстанция" не количественная, а качественная, как перпендикулярная ось к плоскости, к которой - оси - стандартные "плоские метрики" попросту НЕ применимы.

Измерять интеллект деньгами так же глупо, как измерять температуру литрами.

Если бы все задачи сводились в конечном итоге к зарабатыванию, то конечно, но дела обстоят несколько иным образом.

Не деньги определяют ценность ума, а ум определяет и назначает ценность денег.

Да, можно продать и купить плоды умственного труда, но ум - не покупается и не продаётся.

Можно конечно порассуждать и о самом уме как о плоде сознательного бытия, но это уже совсем другая история...

| |||||||

|

create

|

Egg:

)))

Чего стоят деньги без ума ?

И что они тогда определяют ?

)))

(Это очень печальное зрелище, когда человеку, чтобы чувствовать себя <> полноценным, приходится удобрять свой ум звонкой монетой. Выглядит как обезьяна, применившая гранату к собственной голове.)

p.s.

Вы постоянно путаетесь в показаниях и происходит это по одной единственной причине: Вы глубоко не в теме. Поймать Вас ничего не стоит, но это настолько никчёмное и скучное занятие, что жаль на него даже минимального времени. Как профессиональный потребитель, Вы занимаете свою насиженную нишу - это нормально и естественно, и было бы ещё лучше, если бы Вы из неё и не высовывались.)Только нищеброд будет относиться к деньгам как сущности (для того, чтобы оправдать своё нищебродство), для умного человека - деньги - это универсальный инструмент решения многих задач. Они определяют качество решения и возможности. А Ум, который "что-то назначает", что от него не зависит - это Дебильность, мой увядающий друг

| |||||||

|

create

|

Egg:

То есть, когда вы работаете с чатботом, то зарабатывает он ..., а вы при нем - нищеброд.... такое получается хорошее определение.

Для зарабатывания автономный агент должен обладать субъектностью, а этого нет даже в прогнозах.Microsoft дал своё определение AGI - когда автономный агент заработает свои первые 100 ярдов. И это хорошее определение,

| |||||||

|

create

|

Ну о каком интеллекте естественном и тем более искусственном можно разговаривать с бухгалтером ?

| |||||||

|

write

|

Еще пару слов по теме, если никто не возражает.

Шолле суть говорит о том, система должна решать задачи, обладающие новизной. Проверка преодоления решателем новизны заключается в том, что в тесты должны быть включены задачи, не похожи на обучающие. В пределе - обучающие задачи никак не связаны с тестовыми. Тогда обучающие задачи совершенно бесполезны для решения "абсолютно" новых задач. Доводя до конца эти рассуждения, приходим к ситуации, когда система должна решать задачи вообще без обучения.

Мне трудно представить, чтобы это можно было бы сделать с помощью LLM, когда нет данных, и, следовательно, нет возможности обучения. Поэтому в o3(tuned) методы, альтернативные LLM, как минимум, на равных используются с LLM. Альтернативные методы предполагают поиск в пространстве программ, включающий, о чудо, перебор с возвратом: "search process has to explore an enormous number of paths through program space – including backtracking". Главный фокус заключается в том, что в "пространстве программ" для данной задачи можно использовать критерий "простоты" программы и решать (простые) задачи без какого-либо обучения. Поэтому относительный успех o3(tuned) приписывать исключительно LLM вряд ли корректно.

Насчет библиотек/сервисов ai и денег. LLM в качестве "интерактивной энциклопедии", несомненно, - впечатляющее достижение. Но сколько бы мои коллеги не пытались применить LLM в коммерческих целях для наших задач - да, частично работает, однако шкурка выделки не стоит. Пытались применять копилот - то же самое, а потом вышли на исследование, доказывающие коммерческую неэффективность использования (ссылки, увы у меня сейчас нет). Использование убыточных технологий противоречит самой сути коммерции.

Если рассматривать прохождение тестов Шолле еще и для оценки коммерческой эффективности, то опять смотрим график здесь:

https://arcprize.org/blog/oai-o3-pub-breakthrough

Отсекаем решатели по порогу ручного решения (5$ на задачу), и видим, что ни o1, ни o3 экономически не целесообразны. А вот решатель, полученный в соревновании Kaggle (Kaggle Sota) тратит на одну задачу несколько десятков центов. Поэтому применение этого решателя вполне может быть целесообразно, но нужно учесть нюанс. Т.к. точность решателя Kaggle невысока - 55%, то за ним потребуется ручная проверка. Если решением была "формула" или "программа", тогда было бы понятно, как задачи решаются. Тогда проверка может стоить относительно недорого и можно не превысить 5$ на задачу. А если "формула" - это коэффициенты в сети, то для проверки потребуется заново решать решенные ai задачи. Т.е. и решатель от Kaggle также будет коммерчески бесполезен, пока не наберет точности, либо не будет ясно сообщать, как задача решается.

| |||||||

|

create

|

Egg:

Ну ,если для вас зарабатывающий не является субъектом, то вы этим унизили себя до статуса "неживой объект".Цап:

Опять Вам кто-то что-то должен))) Погуглите, что такое investments, assets и profit))) Удивительно, конечно, Вам все должны, а Вы не знаете, что такое доход и прибыль))Для зарабатывания автономный агент должен обладать субъектностью, а этого нет даже в прогнозах.

| |||||||

|

create

|

Egg:

Так вы не отличаете "приносит доход" от "зарабатывает". Детский сад.

В определении, которое вы приводили, используется слово "заработает".

Цап:

Вы - идиот? У меня есть недвига, которая мне приносит доход и прибыль, она - субъект и живая? ))))))Ну ,если для вас зарабатывающий не является субъектом, то вы этим унизили себя до статуса "неживой объект". Egg: Microsoft дал своё определение AGI - когда автономный агент заработает свои первые 100 ярдов. И это хорошее определение,

| |||||||

1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| Главная | Участники | Жалобы | Поиск | Исходный код | О форуме |